-

日期: 2025-05-06 | 來源: 量子位 | 有0人參與評論 | 字體: 小 中 大

大模型集體“翻車”?DeepResearch勉強破肆成,絕大多數連10%都不到

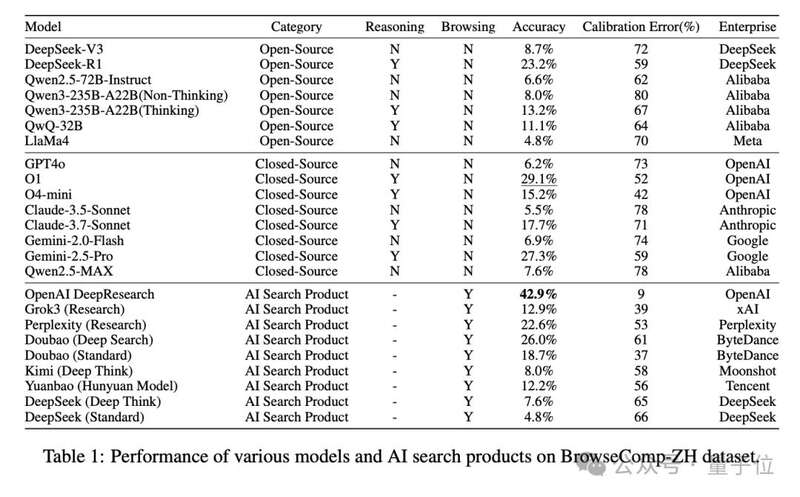

在BrowseComp-ZH的測試下,多款國內外主流大模型集體“翻車”:

盡管這些模型在對話理解、生成表達方面已展現強大實力,但在面對中文互聯網的復雜檢索任務時,准確率普遍低得驚人:

多數模型准確率低於10%,僅少數能突破20%

OpenAI DeepResearch以42.9%位列第壹,仍遠未“及格”

研究者指出,這壹結果說明:模型不僅需要會“查資料”,更要會“多跳推理”與“信息整合”,才能在中文互聯網中真正找到答案。

肆大發現,揭示中文網頁任務的“模型死角”1. 僅靠記憶不行,得真本事

純靠參數記憶(無搜索)的模型准確率往往低於10%,說明“硬背”不靠譜。

2. 有推理的模型,表現更好

DeepSeek-R1(23.2%)比DeepSeek-V3(8.7%)整整高出14.5%,Claude-3.7也比Claude-3.5提升了12.2%,推理能力成為關鍵變量。

3. 搜得多 ≠ 搜得准,多輪策略才是王道

具備多輪檢索能力的AI搜索產品全面勝出:

DeepResearch:42.9%

豆包Deep Search:26.0%

Perplexity Research模式:22.6%

相比之下,只檢索壹次的模型(如Kimi、Yuanbao)准確率低至個位數。

4. 搜索功能“翻車”?接入反而變差

最典型的反例是DeepSeek-R1,開啟搜索功能後准確率從23.2%斷崖式跌至7.6%。

研究指出,模型未能將網頁檢索信息與已有知識有效融合,反而被誤導。

數據集開放!歡迎模型開發者挑戰BrowseComp-ZH的全部數據已開源發布。

研究者希望此基准測試能成為推動LLM在中文信息環境落地的試金石,助力構建真正“會用中文上網”的智能體。

下壹步,他們計劃擴充樣本規模,拓展問答形式,並深入分析模型推理路徑與失敗案例。- 新聞來源於其它媒體,內容不代表本站立場!

-

原文鏈接

原文鏈接:

目前還沒有人發表評論, 大家都在期待您的高見